Por Rodrigo Firmino, Gilberto Vieira, Julia Abad e Henrique Kramer, originalmente publicado aqui.

A proposta de videomonitoramento Smart Sampa, da Prefeitura de São Paulo, parece extraída, seletivamente, de um dos versos da canção de Caetano Veloso, quando ainda se estranha com a imensa metrópole: “Quando eu te encarei frente a frente não vi o meu rosto; chamei de mau gosto o que vi, de mau gosto, mau gosto”. O projeto é um exemplo sublime e criminoso de mau gosto no que diz respeito ao uso de tecnologias digitais e gestão com foco nos sistemas urbanos e no uso de câmeras para o monitoramento das dinâmicas da cidade. Ele é complexo e tem várias dimensões problemáticas, mas vamos tratar aqui das mais absurdas: a proposta global de implementação de uma vigilância ampliada e transversal, fruto do objetivo de integração entre sistemas e setores da administração municipal; e o uso de tecnologias de reconhecimento facial com foco expressamente dirigido a segregação racial e social.

Como se já não bastassem todas as evidências que justificam o banimento de tecnologias de reconhecimento facial na administração pública, a Prefeitura resolveu ampliar a controvérsia ao apresentar projeto para contratação de um sistema cuja estrutura racista de funcionamento se dá de forma explícita e inaceitável, expressa no próprio texto do edital, prevendo a detecção de cor da pele das pessoas sob “o olhar” das câmeras. No termo de referência da licitação, consta como requisito dos analíticos de rastreamento de pessoas, a capacidade de:

“Reconhecimento simultâneo de várias faces em um fluxo de vídeo. As imagens dos rostos são salvas com data, hora e local de acesso. Detecção de face coberta(óculos, barbas e diferentes tipos de cabelo, etc.) […] rastrear uma pessoa suspeita, monitorando todos os movimentos e atividades. A pesquisa deve ser feita por diferentes tipos de características como cor, face, roupas, forma do corpo/aspecto físico e outras características.”

Tarcízio Silva, em matéria publicada pelo Portal UOL sobre o edital Smart Sampa, destaca que “no caso de reconhecimento facial no espaço público, não há lugar para o recurso em sociedades democráticas, antidiscriminatórias e livres”. E não se pode alegar desconhecimento por parte da Prefeitura de São Paulo. O viés racista e discriminatório dos algoritmos de reconhecimento facial tem sido amplamente documentado e divulgado, inclusive fora do âmbito acadêmico especializado. Além das várias possibilidades de detecção de face e uso de atributos de reconhecimento étcnico, segundo o edital o sistema deve prever a identificação de atitudes consideradas suspeitas, como tempo de permanência em determinados locais, fluxos e aglomerações, “mendicância” e “vadiagem” além de

“Comportamentos suspeitos dentro de uma determinada área (pichação / acesso indevido, mendicante em cruzamento).”

O edital tem como objetivo a contratação de estrutura técnica e de gestão para uma plataforma de automação de vigilância e monitoramento, que prevê a integração e interoperabilidade de vários sistemas de coleta e processamento de informações sobre pessoas, veículos, perímetros territoriais e detecção de movimentos e fluxos. A contratação envolveria a constituição de “serviços que componham uma solução Plataforma Inteligente”, e

“busca a modernização e ampliação no monitoramento de câmeras na Capital, agregando o conceito de Cidades Inteligentes. A iniciativa permitirá maior eficácia e agilidade no atendimento de ocorrências da Guarda Civil Metropolitana e demais órgãos de segurança. A Smart Sampa possibilitará um monitoramento mais inteligente e especializado graças ao uso de analíticos, permitindo que os órgãos de segurança possam promover a filtragem instantânea de imagens de ocorrências.”

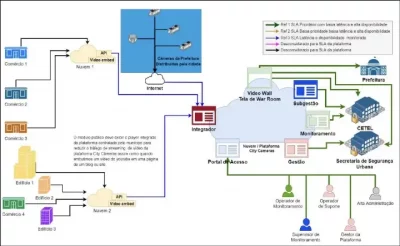

Fluxos propostos para a plataforma Smart Sampa. Fonte: Termo de Referência, Consulta Pública, 2022.

Fluxos propostos para a plataforma Smart Sampa. Fonte: Termo de Referência, Consulta Pública, 2022.

Sem nenhuma surpresa, todo o vocabulário neoliberal de cidades inteligentes, centros de controle, salas de situação (war rooms), serviços eficientes e solucionismo tecnológico é empregado nas justificativas do projeto. Está prevista a instalação de 20 mil câmeras novas e dois tipos de integração com câmeras já existentes: integração com 10 mil câmeras de empresas concessionárias, e outras 10 mil câmeras de munícipes. O investimento é de cerca de R$70 milhões por ano e prevê a interoperabilidade de dados e informações com 19 secretarias ou autarquias do município, estado e governo federal, além da capacidade de conexão com drones, câmeras veiculares, bodycams, controle de barreiras, sinalização de trânsito, rastreadores, radares e sensores de diferentes tipos, formando uma ampla plataforma de vigilância de fixos (edifícios, perímetros, territórios, etc.) e fluxos (movimento de cargas e pessoas, informações, dados e infraestruturas) urbanos.

A complexa rede de relações tecnopolíticas que compõem a concepção e implementação de sistemas como este, é o que define seus usos e justificativas para a ampliação de técnicas e práticas de repressão seletivas, racistas e antidemocráticas.

O que são comportamentos suspeitos? Quem define e como são definidas as atitudes e pessoas consideradas suspeitas? Como identificar um acesso indevido, atitudes de mendicância e vadiagem? Tais decisões são ajustadas por um conjunto de atores que envolve os programadores do sistema, os gestores da plataforma, os gestores de sua aplicação (autoridades municipais e estaduais envolvidas no uso da plataforma), e em última instância, os próprios operadores do monitoramento. Grande parte desses ajustes estão embarcados nas linhas de programação dos chamados analíticos.

Os analíticos são programações do software de operação das câmeras, que permitem a automação de reconhecimento de características pré-estabelecidas nas imagens, ou seja, são os algoritmos de gestão dos sistemas de vigilância e monitoramento. O problema de sistemas como o que está sendo proposto, é a definição dos parâmetros de busca e identificação algorítmica, que pode abrigar todo tipo de preconceito, racismo e vigilantismo, próprios de sistemas opressores e persecutórios. A questão está longe de ser uma mera escolha tecnológica ou uma opção por maior eficiência de tecnologias supostamente neutras. Essa construção tecnopolítica se vincula aos problemáticos preceitos de uma polícia preditiva, supostamente capaz de antecipar o crime pelo aprendizado maquínico a partir de registros de delitos passados, como se fosse possível construir padrões de corpos e ações criminosas. Trata-se de uma crença absurda, mas comum, em uma neutralidade na identificação e julgamento do suspeito, realizados por máquinas livres de preconceito e juízo de valor, que funcionariam como base da constituição de cidades mais inteligentes.

De maneira previsível, a Secretaria Municipal de Segurança Pública se defendeu, por meio de nota ao Portal Metrópoles, com o argumento-padrão para justificar o emprego desse tipo de tecnologia, ou seja, que o “reconhecimento facial permitirá a busca por pessoas desaparecidas, crianças perdidas em grandes eventos e objetos perdidos”, ainda que seja curioso tentar entender como algoritmos treinados para reconhecer faces humanas (mesmo que com alta falibilidade) possam auxiliar na busca por objetos perdidos.

De modo geral, projetos como o Smart Sampa apresentam problemas estruturais, de origem, por seu amplo espectro de vigilantismo, reproduzindo vícios de construção de suspeição e criminalidade próprios de uma estrutura punitivista historicamente falha e que quase sempre recai sobre corpos racializados e periféricos. No Brasil, pessoas negras têm quatro vezes mais chances de serem abordadas pela polícia, quando comparadas a pessoas brancas, como aponta a pesquisa “Por que eu?”, produzida por uma parceria entre o Instituto de Defesa do Direito de Defesa (IDDD) e o data_labe(organização de mídia e pesquisa com sede no Complexo da Maré). Com dados do Fórum Brasileiro de Segurança Pública, o relatório da pesquisa também mostra que, entre 2005 e 2020, a quantidade de pessoas negras na população carcerária brasileira aumentou 15%, enquanto a quantidade de pessoas brancas diminuiu 19%. Sistemas de vigilância com automação algorítmica reforçam, e em muitos casos pioram, os problemas estruturais da justiça criminal e da segurança pública em países como o Brasil.

Imagem: Relatório “Por que eu?”. Fonte: IDDD e data_labe, 2022

Imagem: Relatório “Por que eu?”. Fonte: IDDD e data_labe, 2022

Os dados da pesquisa “Por que eu?” evidenciam que os requisitos definidos no projeto de contratação do Smart Sampa, como “cor da pele” e “outras características” (corte de cabelo, tipo de roupa, jeito de caminhar e maneiras de se divertir em espaços públicos), bem como a definição de “vadiagem” e “mendicância”, normalmente são determinantes na construção de suspeitos-padrão e em apontar corpos e atitudes indesejáveis no ambiente urbano “limpo”, branco, padronizado e seletivo da cidade neoliberal.

Por todas essas razões, é extremamente contraditório chamar de “smart” um projeto medieval cuja estrutura evidencia o foco ilegal no monitoramento e criminalização da população negra, e com referências literais inadmissíveis a resquícios de uma legislação do século XIX e de origem escravocrata, como é o caso da vinculação das câmeras de vigilância à sua capacidade de identificar vadiagem e mendicância.

Movimentos organizados em torno dos direitos digitais têm acompanhado a proposta de licitação do serviço desde as etapas de consulta pública, e demandam apelo de outros movimentos sociais que sejam capazes de, juntos, impedir que projetos como esse avancem na medida em que colocam em risco direitos fundamentais. A Campanha #TireMeuRostoDaSuaMira publicou carta de repúdio apontando as possíveis violações caso o projeto avance. A iniciativa surgiu como uma ação da sociedade civil para reconstruir a relação entre medo da criminalidade e segurança pública. Ações da campanha têm demonstrado que tecnologias de videomonitoramento não são capazes de diminuir a violência urbana, sendo em verdade mecanismos de inviabilidade de direitos inerentes aos sujeitos, como da igualdade e não-discriminação, na medida que acompanham as realidades segregadoras e racistas do sistema de justiça criminal.

Imagem: campanha #tiremeurostodasuamira. Fonte: divulgação tiremeurostodasuamira.org.br, 2022.

Imagem: campanha #tiremeurostodasuamira. Fonte: divulgação tiremeurostodasuamira.org.br, 2022.

Uma das estratégias que têm avançado significativamente é mobilizar parlamentares com atuação legislativa e executiva e trabalhar em projetos de litigância e advocacy que produzam outras propostas e narrativas para a administração pública e planejamento urbano. Neste sentido, no segundo semestre de 2022, a iniciativa #SaiDaMinhaCara foi responsável pelo protocolo de 50 projetos de lei pelo banimento do reconhecimento facial em espaços públicos, todos fundamentados na violação de direitos fundamentais que o uso desta tecnologia acarreta, transformando os ambientes públicos de encontros em locais passíveis de criminalização para a população no geral.

É fundamental que este debate avance nos circuitos acadêmicos, nos gabinetes da administração pública e, principalmente, nos comitês e assembleias dos movimentos de base. Além disso, é importante difundir informações sobre as limitações desse tipo de tecnologia para o público em geral, com a finalidade de criar uma conscientização sobre os problemas estruturais da justiça criminal e da segurança pública no país, reforçadas por projetos baseados em um falso solucionismo tecnológico. Assim, talvez seja possível imaginar cidades inteligentes para todas e todos e, quem sabe, um “outro sonho feliz de cidade”.